сервер отвечает редиректом на запрос robots txt что это

Сервер отвечает редиректом на запрос /robots.txt (яндекс)

При переезде сайтом на https

В яндекс вебмастере пишет «сервер отвечает редиректом на запрос /robots.txt »

Робот не смог получить доступ к файлу robots.txt при последнем обращении. Из-за отсутствия параметров индексирования и инструкций в поиск могут попасть нежелательные страницы.

Сервер отвечает редиректом на запрос /robots.txt

Яндесу указал на переезд сайта вот что пишет «В ближайшее время в результатах поиска вместо домена volstamp.in.ua появится https://volstamp.in.ua

Если настраивали редирект в Htaccess, сделайте исключение для robots.txt

RewriteEngine On

RewriteCond %

RewriteCond %

RewriteRule (.*) https://%

Спасибо, вот что сделал)

RewriteEngine On

RewriteBase /

RewriteCond %

RewriteCond %

RewriteRule ^(.*)$ https://volstamp.in.ua/$1 [R=301,L]

Директива Host известна только Яндексу

User-agent: *

Disallow: /my/

Disallow: /checkout/

Disallow: /cart/

Disallow: /webasyst/

Disallow: /search/?query=

Disallow: /compare/

Disallow: /tag/

Disallow: *&sort=

Disallow: */?sort=

Disallow: /signup/

Disallow: /login/

Disallow: /forgotpassword/

User-agent: Yandex

Disallow: /my/

Disallow: /checkout/

Disallow: /cart/

Disallow: /webasyst/

Disallow: /search/?query=

Disallow: /compare/

Disallow: /tag/

Disallow: *&sort=

Disallow: */?sort=

Disallow: /signup/

Disallow: /login/

Disallow: /forgotpassword/

Host: https://volstamp.in.ua

Добрый день! у меня такая же проблема, не пойму что менять в моем htaccess:

RewriteCond %

RewriteRule ^(.*)$ http://odda.com.ua/$1 [L,R=301]

RewriteRule ^(.*)\.tpl$ [R=404]

RewriteRule ^(.*)\.zip$ [R=404]

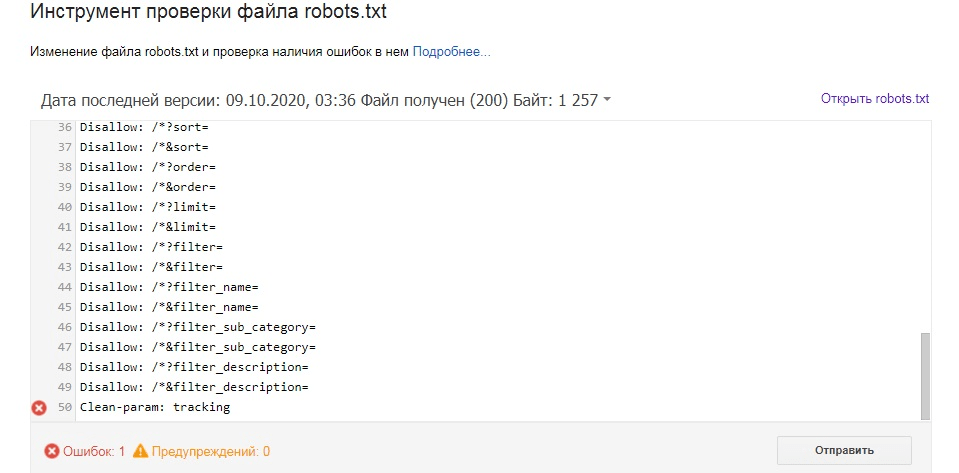

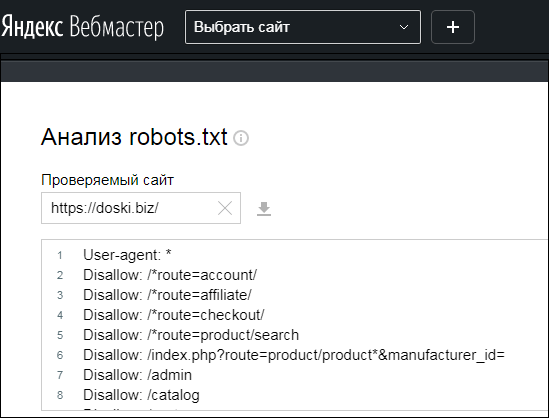

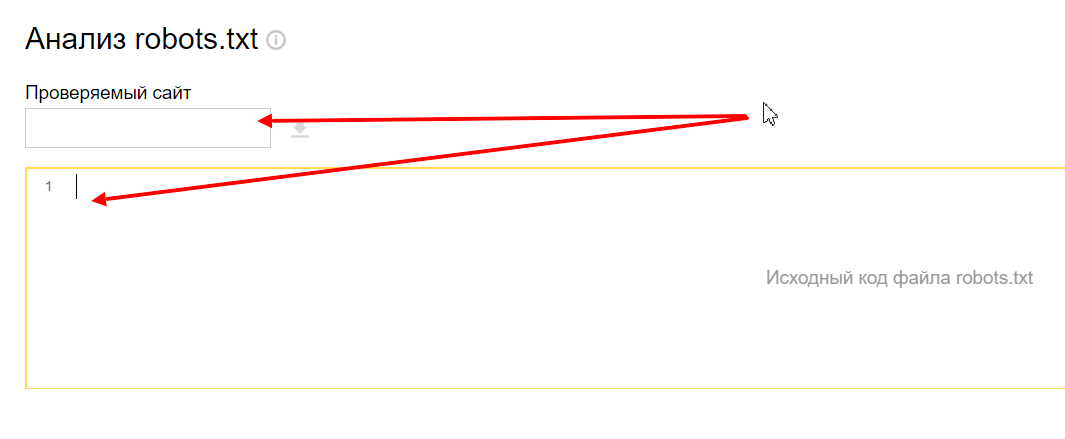

Для чего нужен файл robots.txt? Как его настроить и проверить

Файл robots.txt — это текстовый документ в корневом каталоге сайта с информацией для поисковых роботов о том, какие URL (на которых расположены страницы, файлы, папки, прочее) стоит сканировать, а какие — нет. Наличие этого файла не является обязательным условием для работы ресурса, но в то же время правильное его заполнение лежит в основе SEO.

Решение об использовании robots.txt было принято еще в 1994 году в рамках «Стандарта исключений для роботов». Согласно справке Google, файл предназначен не для запрета показа веб-страниц в результатах поиска, а для ограничения количества запросов роботов к сайту и снижения нагрузки на сервер.

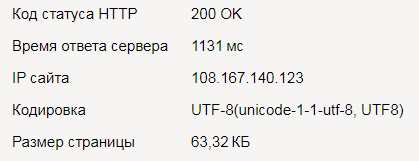

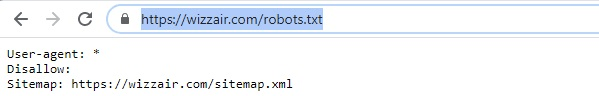

В целом содержимое robots.txt стоит отнести к разряду рекомендаций поисковым ботам, задающих правила сканирования страниц сайта. Чтобы увидеть содержимое robots.txt на любом сайте, нужно добавить к имени домена в браузере /robots.txt.

Для чего используют robots.txt?

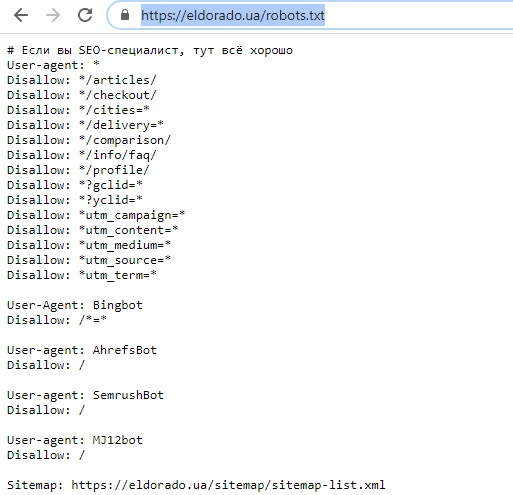

К основным функциям документа можно отнести закрытие от сканирования страниц и файлов ресурса в целях рационального расхода краулингового бюджета. Чаще всего закрывают информацию, которая не несет ценности для пользователя и не влияет на позиции сайта в поиске.

| Примечание. Краулинговый бюджет — количество страниц сайта, которое может просканировать поисковый робот. Для его экономии стоит направлять робота только к самому важному содержимому ресурса, закрывая доступ к малополезной информации. |

Какие страницы и файлы закрывают с помощью robots.txt

1. Страницы с персональными данными.

Это могут быть имена и телефоны, которые посетители указывают при регистрации, страницы личного кабинета, номера платежных карт. В целях безопасности доступ к этой информации стоит дополнительно защищать паролем.

2. Вспомогательные страницы, которые появляются только при определенных действиях пользователя.

К ним можно отнести сообщения об успешно оформленном заказе, клиентские формы, страницы авторизации или восстановления пароля.

3. Админпанель и системные файлы.

Внутренние и служебные файлы, с которыми взаимодействует администратор сайта или вебмастер.

4. Страницы поиска и сортировки.

На страницы, которые отображаются по запросу, указанному в окне поиска на сайте, как правило, ставят запрет сканирования. Это же относится к результатам сортировки товаров по цене, рейтингу и другим критериям. Исключением могут быть сайты-агрегаторы.

5. Страницы фильтров.

Результаты, которые отображаются после применения фильтров (размер, цвет, производитель и т.д.), являются отдельными страницами и могут быть расценены как дубли контента. SEO-специалисты, как правило, ограничивают их сканирование, за исключением ситуаций, когда они приносят трафик по брендовым и другим целевым запросам.

6. Файлы определенного формата.

К ним могут относиться фото, видео, PDF-документы, JS-скрипты. С помощью robots.txt можно ограничивать сканирование файлов как по отдельности, так и по определенному расширению.

Как создать и где разместить robots.txt?

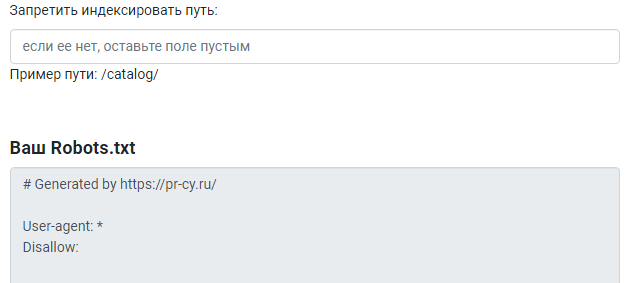

Инструменты для настройки robots txt

Также можно использовать генератор robots.txt. Некоторые сайты предоставляют бесплатные инструменты создания на основании заданных вами условий.

Название и размер документа

Имя файла robots.txt должно выглядеть именно так, без использования заглавных букв. Допустимый размер документа согласно рекомендациям Google и Яндекса — 500 КиБ. При превышении лимита робот может обработать документ частично, воспринять как полный запрет сканирования или, наоборот, пройтись по всему содержимому ресурса.

Где разместить файл

Документ находится в корневом каталоге на хостинге и доступ к нему возможен через FTP. Перед внесением изменений рекомендуется сначала скачать robots.txt в исходном виде.

Синтаксис и директивы robots.txt

Теперь разберем синтаксис robots.txt, состоящий из директив (правил), параметров (страниц, файлов, каталогов) и специальных символов, а также функции, которые они выполняют.

Общие требования к содержимому файла

1. Каждая директива должна начинаться с новой строки и формироваться по принципу: одна строка = одна директива + один параметр.

| Ошибка | User-agent: * Disallow: /folder-1/ Disallow: /folder-2/ | |||||||||||||||||||||||||||||||||||||||||||||||

| Правильно | User-agent: * 2. Названия файлов с использованием кириллицы и других алфавитов, отличных от латинского, следует преобразовать с помощью конвертера Punycode.

3. В синтаксисе параметров необходимо придерживаться соответствующего регистра. Если имя папки начинается с большой буквы, название с маленькой буквы дезориентирует робота. И наоборот.

4. Недопустимо использование пробела в начале строки, кавычек для директив или точек с запятой после них.

|